前言

听说spark为了支持python全面研发出一款专门调用api的工具叫做pyspark,因此,本着学习的目的,尝试安装一下pyspark

已有基础

- ubuntu 18.04

- anaconda 4.20

- python 3.8

过程

官网中强调了,要想安装pyspark则最先确保自身的python版本要大于等于3.7,因此,在开始本次教程之前,需要确保自身的python>=3.7

在官网中提出了多种方式去安装 pyspark,其中本文将使用conda的方式去进行安装

创建并进入conda虚拟环境

使用命令:

1 | conda create --name pyspark python=3.8 |

创建一个名为pyspark ,python版本为3.8的环境,并进入到环境当中

安装 JAVA

由于在运行过程中,spark使用的是java语言,因此需要安装java环境

安装教程在另一篇博文中有写,请参考:安装及配置java模块进行安装

安装pyspark

输入命令:

conda install pyspark

进行安装

使用 pyspark

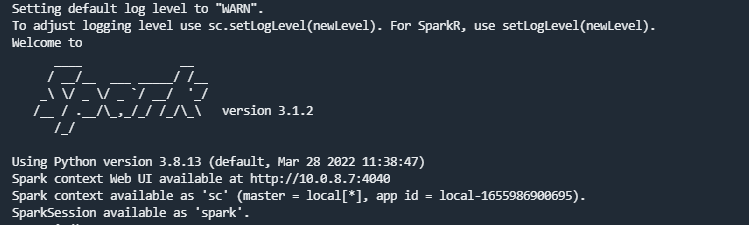

直接终端输入 pyspark即可看到如下界面:

使用 exit()便可退出

其他

测试demo

有待更新